西安网站建设设计的好公司知乎营销平台

卷积神经网络(LeNet)

深层卷积神经网络(AlexNet)

改进:

- dropOut层 - 不改变期望但是改变方差

- ReLU层 - 减缓梯度消失

- MaxPooling

- 数据集数据增强

使用块的网络(VGG)

网络中的网络(NiN)

减少参数

含并行连结的网络(GoogLeNet)

| 参数(M) | 浮点运算(MFlops) | |

|---|---|---|

| inception | 0.16 | 128 |

| 3 * 3 Conv | 0.44 | 346 |

| 5 * 5 Conv | 1.22 | 963 |

模型小 参数少 结构复杂(代码多)

V2 + BN -> V3 换卷积 -> V4 加入残差

批量规范化(BN)

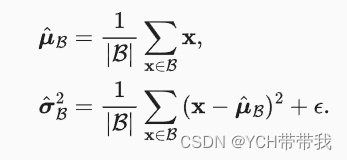

BN(x)=γ⊙x−μ^Bσ^B+β.\mathrm{BN}(\mathbf{x}) = \boldsymbol{\gamma} \odot \frac{\mathbf{x} - \hat{\boldsymbol{\mu}}_\mathcal{B}}{\hat{\boldsymbol{\sigma}}_\mathcal{B}} + \boldsymbol{\beta}.BN(x)=γ⊙σ^Bx−μ^B+β.

因此我们通常包含 拉伸参数(scale)γ\boldsymbol{\gamma}γ

和偏移参数(shift)β\boldsymbol{\beta}β,它们的形状与相同。

请注意,γ\boldsymbol{\gamma}γ和β\boldsymbol{\beta}β是需要与其他模型参数一起学习的参数。

我们在方差估计值中添加一个小的常量ϵ>0\epsilon > 0ϵ>0

,以确保我们永远不会尝试除以零,即使在经验方差估计值可能消失的情况下也是如此。

估计值μ^B\hat{\boldsymbol{\mu}}_\mathcal{B}μ^B和σ^B{\hat{\boldsymbol{\sigma}}_\mathcal{B}}σ^B

通过使用平均值和方差的噪声(noise)估计来抵消缩放问题。 乍看起来,这种噪声是一个问题,而事实上它是有益的。

出现背景:backward时深层训练较快(深层语义),而浅层收敛慢(简单纹理)

思想:让每一层尽量服从同一分布,线性变换,使模型比较稳定

| 作用 | 作用在 | ||

|---|---|---|---|

| 全连接 | 特征维 | 激活函数前 | mean = X.mean(axis=0) |

| 卷积层 | 通道维 | 激活函数前 | mean = X.mean(axis=(0, 2, 3), keepdims=True) |

只能加速收敛不能够增强精度

预测过程中的批量规范化

残差网络(ResNet)

稠密连接网络(DenseNet)Dense-全连接

泰勒公式 f(x)=f(0)+f′(0)x+f′′(0)2!x2+f′′′(0)3!x3+….f(x) = f(0) + f'(0) x + \frac{f''(0)}{2!} x^2 + \frac{f'''(0)}{3!} x^3 + \ldots.f(x)=f(0)+f′(0)x+2!f′′(0)x2+3!f′′′(0)x3+….

ResNetf(x)=x+g(x).f(\mathbf{x}) = \mathbf{x} + g(\mathbf{x}).f(x)=x+g(x).

x→[x,f1(x),f2([x,f1(x)]),f3([x,f1(x),f2([x,f1(x)])]),…].\mathbf{x} \to \left[ \mathbf{x}, f_1(\mathbf{x}), f_2([\mathbf{x}, f_1(\mathbf{x})]), f_3([\mathbf{x}, f_1(\mathbf{x}), f_2([\mathbf{x}, f_1(\mathbf{x})])]), \ldots\right].x→[x,f1(x),f2([x,f1(x)]),f3([x,f1(x),f2([x,f1(x)])]),…].