门户网站建设关系到洛阳网站seo

引言

今天带来论文Unified Language Model Pre-training for Natural Language Understanding and Generation的笔记,论文标题是 统一预训练语言模型用于自然语言理解和生成。

本篇工作提出了一个新的统一预训练语言模型(Unifield pre-trained Language Model,UniLM),可以同时用于自然语言理解和生成任务的微调。

该模型基于三种语言建模任务来预训练:单向、双向和seq-to-seq预测。统一建模是通过使用共享的Transformer网络和特定的自注意力掩码控制预测所依赖的上下文来实现的。

总体介绍

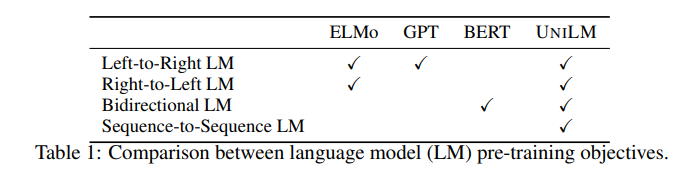

预训练语言模型(LM)通过在大量文本数据上基于上下文预测单词的方式来学习上下文文本表征。不同的预测任务和训练目标被用于预训练语言模型,如表1。

ELMo学习两个单向的LM:一个前向的LM从左到右读取文本,一个反向LM从右到左。GPT使用一个左到右的Transformer来逐单词地预测文本序列。反之,BERT使用双向的Transformer编码器去融合左向和右向的上下文来预测被mask的单词,但它的双向特性使它很难应用于文本生成任务。